L’intelligenza artificiale. A che punto siamo? Opportunità o minaccia

Intervista a Enrico Casartelli a cura di Luigi Torriani Datasys & Datatex Magazine

ENRICO CASARTELLI – Dirigente in IBM per 23 anni, consulente e docente di nuove forme di comunicazione digitale, Enrico Casartelli è anche scrittore, ed è autore dei libri “La vita in una conchiglia”, “Un nove corre in Internet”, “Il vecchio ciliegio di Manhattan”, “Villa Sofia” e “La ribelle primavera del 2030”. Sul Datasys Magazine (anno 2018 n. 1) è già uscita una sua intervista, sul tema “Tecnologia e innovazione. Come vivremo tra vent’anni?”. Sta lavorando al momento a un approfondimento sul tema dell’intelligenza artificiale, in vista di un nuovo libro sull’argomento che è in uscita nel 2020.

1 Intelligenza artificiale, machine learning, robotica: quello che fino a qualche decennio fa appariva fantascientifico oggi è realtà. Nell’ambito dell’intelligenza artificiale quale sono le applicazioni già oggi utilizzate che trovi più interessanti?

È molto corretta la tua affermazione: tutto appariva fantascientifico fino a qualche decennio fa.

La mia prima esperienza in questo campo risale al ’95, fino al ‘99. Allora si parlava di intelligenza artificiale con l’utilizzo di linguaggi proprietari (KT, e ESE Ibm); questi si basavano sulla programmazione logica: un tipo di approccio diverso da quello tradizionale o a oggetti, ma soprattutto complesso perché prettamente scientifico/matematico. Questo problema, aggiunto alla scarsa potenza elaborativa dei calcolatori di allora, forniva dei risultati abbastanza deludenti; la conseguenza fu che io e molti altri lasciammo questo campo con un po’ di scetticismo.

Da cinque anni ho riaffrontato questa realtà e ho visto delle applicazioni incredibili, soprattutto quando l’intelligenza artificiale si unisce alla robotica. Ne cito alcune, presenti anche in YouTube.

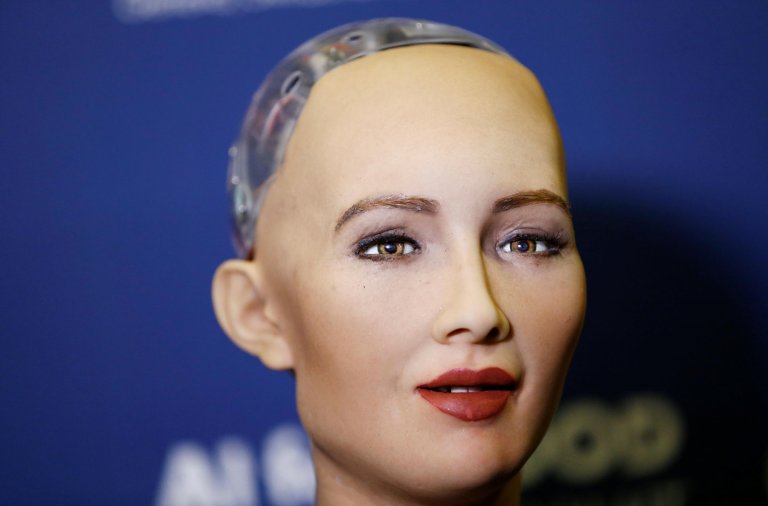

Sophia: un’intelligenza artificiale modellata su un volto assomigliante ad Audrey Hepburn. Dall’aprile del 2015 è sviluppata dalla Hanson Robotics, un’azienda di robotica con base a Hong Kong. Sophia è in grado di interagire con gli esseri umani; famosa una sua intervista con alcuni giornalisti in un evento alle Nazioni Unite il 13 ottobre 2017. Il tono della voce e il viso, con più di 70 espressioni facciali, riflettono il contenuto emotivo delle parole e si ha l’impressione di colloquiare con un essere senziente e autonomo. Un umanoide in continuo sviluppo perché memorizza tutte le sue conversazioni e soprattutto acquisisce informazioni dall’infinito database di Internet.

Jibo, un social robot, è prodotto in collaborazione con la Pixar Animation Studios, azienda della Walt Disney. Jibo assomiglia a una creatura nata da un cartone animato ed è in grado di interagire con i bambini, aiutarli nei compiti, raccontare storie e favole; in sintesi, diventare un loro compagno di gioco. L’obiettivo del progetto è che Jibo rappresenti il motore allegro delle interazioni sociali di un’intera famiglia coinvolgendo anche gli adulti.

Nel lontano giugno del 2017 Lauren Hayes, vicepresidente di una start up di New York ed ex modella, ha presentato l’avatar virtuale Amelia, copia della sua immagine e risultato di tre società: la piccola start up, la multinazionale Accenture e Ipsoft, una famosa compagnia statunitense specializzata nelle tecnologie cognitive e che studia il nostro cervello da 17 anni. Obiettivo già realizzato, ma ovviamente in continua evoluzione: un’instancabile assistente virtuale, che appare sullo schermo di un pc o di uno smartphone, capace di parlare in 40 lingue e dotata di una memoria semantica in cui accumula fatti, nozioni e concetti. Spazia su vari argomenti ed è stata utilizzata in compagnie di tecnologie mediche, istituti di credito e di assicurazione per attività di help desk e formazione. Come Sophia adatta il proprio tono di voce al contenuto emotivo delle parole.

Nell’ultimo Forum Ambrosetti a Villa d'Este Hiroshi Ishiguro, direttore dell'Intelligence Robotics Laboratory dell’università di Osaka, ha lasciato la parola alla sua copia umanoide. Impressionante l’effetto visivo: un busto in lattice che replica il suo volto e che parla e fa smorfie; movimenti delle labbra, battito degli occhi, movimenti del capo e del collo si susseguono in modo logico. Sconcertante l’affermazione di Hiroshi Ishiguro: “Mi sostituisce nelle riunione e conferenze”, e ancora di più il suo obiettivo dichiarato da anni: “Non ho mai voluto costruire una macchina che possa semplicemente svolgere il nostro lavoro, ma qualcosa che ci somigliasse a tal punto da entrare in contatto con noi in maniera empatica”.

Esistono anche moltissimi altri esempi eclatanti, ma mi fermo qui. Da un punto di vista più terreno, girando nei vari laboratori e start up di I.A., ho visto delle realizzazioni di chat bot, (software progettato per simulare una conversazione), uniti a programmi di sintesi vocale avanzata. A parte qualche imperfezione, l’impressione è che parli con un umano: cambio di intonazioni della voce nel timbro femminile o maschile, sospiri, pause… e la risposta alle tue domande è veloce ed esatta.

All’inizio ho detto applicazioni incredibili, senza il minimo dubbio aggiungo anche inquietanti.

2 Nel settore dell’intelligenza artificiale quali potrebbero essere in futuro le novità più strabilianti e di maggior impatto sulla vita delle persone? E quali potrebbero essere delle aree di applicazione insolite, originali, al momento impensate, per l’intelligenza artificiale?

Come ti dissi in una mia precedente intervista, la mia opinione è che possiamo prevedere il mondo futuro a non più di dieci anni, oltre cadremmo in scenari ridicoli e fantascientifici. Questo per un semplice motivo: la tecnologia si evolve con una velocità esponenziale; io spesso per spiegarlo proietto la sequenza di immagini di un bicchiere il cui contenuto si riempie in trenta secondi e in modo esponenziale, solo negli ultimi attimi ci accorgiamo che il liquido arriva all’orlo del bicchiere e trasborda.

Se questo vale nella tecnologia, è ancora più realistico nell’I.A., in cui siamo ancora all’inizio. Di certo spariranno le mansioni ripetitive come centralinisti, call center, addetti al servizio clienti in aeroporti etc.; già questo avviene, e da anni, in ambito industriale.

I più pessimisti affermano che spariranno anche altre figure come consulenti di investimenti finanziari, legali, addetti nel settore turistico e in aree delicate come l’assistenza agli anziani o negli asili. In Giappone, nelle case di cura i social robot, in particolare ELLIQ, già operano da anni, ma è una cultura molto diversa dalla nostra. Sinceramente non mi vedo fra qualche anno assistito da un robot, né avrò un coraggio tale da affidare dei bambini a un robot, o forse sì, ma con la presenza e il supporto di maestre sorridenti.

Noi abbiamo un patrimonio culturale e turistico immenso, che sarà il futuro del nostro P.I.L., e ora sono io a porti una domanda: “Luigi, seguiresti un robot guida in una visita a un museo oppure affideresti la tua libreria a un robot assistente?”, penso proprio di no. L’anno scorso in Scozia è avvenuto il primo licenziamento di un robot utilizzato come commesso in un supermercato di Edimburgo, semplice il motivo: i clienti lo evitavano.

Nella medicina gli algoritmi di apprendimento dell’I.A. potranno ottenere informazioni sempre più precise sulla diagnostica, sui processi di cura, sulla variabilità del trattamento e sui risultati dei pazienti. Già oggi l’I.A. è capace di identificare con grande precisione le malattie (come i tumori) nelle immagini radiologiche; questo grazie alla possibilità di un accesso istantaneo a un patrimonio storico di dati non alla portata di un singolo dottore o di un’equipe medica. Anche qui molti affermano che i medici chirurgi spariranno grazie alla nanotecnologia e alla robotica.

Ti strappo un piccolo sorriso (spero). Come sai, pochi mesi fa, ho subito un intervento agli occhi; dopo un’ora di preparativi entro in sala operatoria e il primario, con cui avevo raggiunto quasi un rapporto di amicizia, mi chiede: “Carissimo Casartelli, iniziamo?”. “Sì, ma subito e, per favore, facciamo in fretta. Qui fa un freddo polare”, la mia risposta un po’ scherzosa, ma non troppo; dopo pochi secondi sento le sue parole che mi gelano ancora di più: “Non funziona la macchina laser”. Seguono minuti, per me ore, di colloqui febbrili tra lui e l’assistente, anche qualche imprecazione, finché il primario ordina: “Spegni e riaccendi”, e poco dopo aggiunge con tono tranquillo: “Casartelli, il laser funziona, ora possiamo iniziare”. Terminata l’operazione, non prima, ho (quasi) sorriso ricordando che era la stessa operazione che si faceva qualche anno fa quando i PC si bloccavano. Mi chiedo: “Che reazione avrei avuto se mi avesse parlato un robot anziché una persona?”

Ritornando alla tua domanda: gli umanoidi, basati sulla robotica, nanotecnologie e I.A., saranno sempre più “precisi” e reattivi. Microcellule artificiali formeranno la cute e ne imiteranno perfettamente le reazioni: rossori, gonfiori, macchie etc. e, se colpite da urti o altri effetti, invieranno al cervello artificiale segnali che simulano il dolore umano o altre sensazioni. Aggiungi le Amelie o le Sophia che ti accennavo prima e otterremo dei perfetti umanoidi. Quando? Secondo me prima del prossimo decennio e sai che non amo la fantascienza.

3 Google, Amazon, Apple, Ibm, Microsoft, Oracle, ecc.: secondo te chi vincerà – tra i giganti – la sfida dell’intelligenza artificiale? A chi andrà la fetta più importante del business?

Si definiscono 6+3 le potenze di Internet. Da una parte le sei americane Google, Microsoft, Apple, Facebook, Ibm, Amazon (raggruppate nell’acronimo, per noi triste, G-MAFIA); dall’altra parte le tre cinesi Baidu, Alibaba, Tencent (acronimo Bat, pipistrello).

La sfida nell’I.A. si sta evolvendo non più tra le compagnie, ma tra i governi: il Pentagono e il potere di Xi Jinping, quest’ultimo ha dichiarato un investimento di 150 miliardi di dollari per arrivare al dominio del settore nel 2030. La Cina, con le numerose start up, oggi sembra alla pari, o superiore, nel software, ma inferiore nell’hardware, infatti sta investendo nella ricerca sui semiconduttori.

Tra le società americane Google, anche grazie ai suoi storici profitti, è quella che finora ha investito maggiormente, non solo nell’I.A., ma in tutti i servizi web legati ai big data. Ha creato, seguita da Facebook, i primi laboratori di machine learning in quanto attraverso il suo motore di ricerca e il suo browser ha un’infinità di dati a disposizione. Oggi chi ha maggior potere non più chi elabora efficacemente i dati, ma chi li possiede. Però il 2018 è stato un anno terribile per Google, a causa della scoperta del progetto Dragonfly, e soprattutto per Facebook travolta dallo scandalo Cambridge Analytics con tutte le conseguenze sul governo di Trump.

Il 9 gennaio, nel Consumer Electronics Show (Ces) di Las Vegas, Ibm ha presentato il primo computer quantistico commerciale. Il quantum computing, finora relegato in laboratori, darà un’ulteriore spinta allo sviluppo dell’I.A. in ambito commerciale.

Chi vincerà tra le due potenze? Non lo so, l’Asia sembra avvantaggiata anche perché Google e Microsoft, in aperto contrasto con la politica di Trump, hanno sempre investito in Cina con centri di ricerca a Pechino. E la Russia guarda e basta? Penso proprio di no, Vladimir Putin ha dichiarato: “Chi dominerà l’I.A., dominerà il mondo”.

4 Stephen Hawking, il celebre astrofisico scomparso nel 2018, ha dichiarato nel 2017: “il successo nella creazione dell’intelligenza artificiale potrebbe essere il più grande evento nella storia della nostra civiltà. O il peggiore. Non lo sappiamo. Non possiamo sapere se l’Intelligenza Artificiale ci aiuterà o ci distruggerà”. Che ne pensi?

È la domanda che mi aspettavo, la più inquietante, ma anche la più affascinante perché siamo di fronte a una realtà ancora agli inizi e dagli sviluppi inimmaginabili, come internet; chi negli anni novanta ne prevedeva una rivoluzione tale da cambiare il nostro modo di lavorare e vivere? Un progresso che non è ancora terminato, anzi.

Nell’intelligenza artificiale siamo di fronte a due teorie opposte.

Isaac Asimov scriveva: “Un robot non può recare danno agli esseri umani e deve obbedire ad essi…”, con tre leggi sulla robotica ben definite.

Louis Dal Monte scrive: “Entro il 2040 le macchine dotate di intelligenza artificiale compiranno l’incredibile sorpasso sugli esseri umani. La specie vivente dominante non sarà più l’umana, ma quella delle macchine; questa acquisirà autocoscienza e conquisterà la capacità di autoproteggersi, potrà persino vedere gli umani nello stesso modo in cui noi oggi ci relazioniamo con le più fastidiose specie di insetti…”

Mi piace essere realistico e riporto alcuni fatti.

Agosto 2017, in un laboratorio di I.A. di Facebook due chatbot dialog agents, (programmi in grado in grado di imparare e di interagire tra di loro e con l’essere umano), hanno iniziato a dialogare tra loro in una lingua sconosciuta, nuova e che i ricercatori non sono stati in grado di comprendere. In altre parole, hanno dimostrato la loro potenzialità nel creare un linguaggio senza il supporto dell’essere umano, gradualmente hanno abbandonato le regole grammaticali e sintattiche modificando l’inglese fino a creare qualcosa di nuovo. La mia domanda è questa: “Hanno creato un linguaggio incomprensibile per l’essere umano al fine di esserne indipendenti e per dialogare tra loro senza interferenze?”

Nel lontano 2009 nella École Polytechnique Fédérale di Losanna, è stato eseguito un esperimento: mille robot di I.A., divisi in 10 gruppi differenti, erano stati programmati per inviare un segnale in caso trovassero una buona risorsa e quindi per aiutare gli altri del medesimo gruppo ad individuarla. Lo spirito collaborativo è scemato. Dopo 500 prove di questo processo evolutivo, il 60 per cento dei programmi, spinti da un istinto di sopravvivenza, avevano imparato a “barare”, cioè non inviavano alcun messaggio in caso di rinvenimento di qualcosa di positivo e lo inviavano in prossimità di risorse negative. Tutto questo per ingannare i propri simili e riservare per sé ogni utilità. Mie domande: “Perché hanno mentito? Perché dei robot hanno provato un senso di sopravvivenza tale da ingannare i loro simili?”. “E, se hanno un senso di sopravvivenza, hanno maturato anche una presa di coscienza di sé come identità singola in rapporto ontologico con altre singole identità?”

Se tu guardi un filmato di Sophia, l’androide che ti accennavo prima, questa di fronte a uno scienziato che l’ha sviluppato si chiede: “Se io sono una versione migliorata di un precedente modello di Sophia, sono ancora Sophia? Altrimenti chi sono?”, per poi porre questa domanda con curiosità allo scienziato, che ovviamente non sa cosa rispondere. Mia domanda: “Perché questo programma di I.A. si si pone delle domande che assomigliano a una riflessione umana sul concetto di identità?”

Dal 2013 le compagnie di deep learning hanno avuto uno sviluppo incredibile, si rifanno alla rete neurale del sistema nervoso umano e copiano il lavoro che avviene nelle aree del cervello in cui si sviluppa l’apprendimento e l’associazione di idee. Matthew Zeiler, fondatore di Clarifai, afferma “I nostri computer iniziano a ragionare come le persone. Nessuno sa bene come funziona il nostro cervello, ma la mia tecnologia è in grado di fare delle previsioni, come accade nella mente umana, anzi, riusciamo a suggerire al consumatore cose che nemmeno sapeva di volere”.

Ci sono molti altri casi, ma fermiamoci qui. Appare chiaro che ci stiamo sempre più avvicinando alla frase catastrofica di Louis Dal Monte e allontanandoci da quella positiva di Isaac Asimov. Raymond Kurzweil, collaboratore di Google dal 2012 nel machine-learning, ritiene che entro il 2040 le macchine saranno in grado di superare il test di Turing, vale a dire il test che determina se una macchina sia in grado o meno di pensare autonomamente, uno stadio a cui androidi come Sophia non sono ancora arrivati. Un mio personale dubbio: “Forse ci siamo già arrivati in qualche laboratorio, probabilmente cinese, ma è stato opportunamente nascosto come segreto industriale”.

Esiste un altro rischio: si formerà un’empatia tale tra il robot e l’essere umano che quest’ultimo ne potrebbe subire un attaccamento effettivo, soprattutto se pensiamo a persone deboli o isolate. Già questo accade in Giappone nelle strutture di ricovero per anziani e nelle scuole.

Quando presento il mio ultimo libro ambientato in una futura società del 2030, racconto di un personaggio che vive isolato in suo mondo: un guscio protettivo in cui l’assistente virtuale, sempre pronto a intervenire e a consigliarlo, rappresenta l’unica compagnia. Mentre lo descrivo parecchi sorridono con un chiaro scetticismo, io di solito abbasso gli occhi e cambio discorso altrimenti scivolerei in questo delicato argomento provocando delle sterili polemiche.

Cito un caso: agosto 2018, all’università tedesca di Duisburg-Essen viene condotta una sperimentazione su 89 volontari non ricercatori, obiettivo: spegnere un umanoide. Appena prima di disattivarlo il robot ha implorato i volontari, che hanno partecipato all’esperimento singolarmente, di non farlo. Risultato: tutti hanno reagito emotivamente, una parte assecondando la volontà dell’umanoide di non spegnimento e una parte ritardando il più possibile l’esecuzione del comando. Mie domande: “E’ la dimostrazione che l’emotività entra in gioco anche con gli esseri digitali? Che cosa succede se un robot chiede aiuto all’uomo? Se fa leva sui suoi sentimenti e la sua emotività?” La risposta in questo caso è chiara: “L’uomo reagisce con un certo livello di vulnerabilità; prova empatia e un senso di compassione nei confronti della macchina, che lo induce a essere più accondiscendente o addirittura a cedere alle sue richieste”.

Già trent’anni fa lo scrittore Asimov descriveva un quadro fantascientifico basato sull’affetto reciproco tra un robot e una bambina e la disperazione di questa quando le viene sottratto il robot. La mamma angosciata dice alla figlia: “Gloria perché piangi? Robbie era solo una macchina!”, “No! Non era una macchina”, le risponde Gloria, “Era un amico. Io rivoglio Robbie!”.

La conclusione è quindi nelle parole di Stephen Hawking della tua domanda, in sintesi: “Stiamo attenti! Non possiamo sapere se l’intelligenza artificiale ci aiuterà o ci distruggerà!”. Non a caso prima citavo l’intervento di Hiroshi Ishiguro nell’ultimo Forum Ambrosetti: conscio del potere mediatico dell’evento, ha fatto parlare la sua copia umanoide con l’intento di inviare un chiaro monito agli economisti e giornalisti.

Lo scorso 25 aprile la Commissione Europea ha delineato una prima versione delle linee guida sull’intelligenza artificiale e robotica: cinque principi fondamentali per definire un approccio etico su quest’argomento. Anche qui molto scetticismo che io non condivido affatto.

Mi permetto di suggerire un libro a chi vuole approfondire quest’argomento, soprattutto ai più diffidenti: “L'ultimo sapiens: viaggio al termine della nostra specie”, recentemente pubblicato e che purtroppo non ho ancora avuto il tempo di leggere, se non la presentazione. Esiste una paura nell’essere umano: la propria estinzione; l’homo sapiens, dopo la scomparsa del suo antagonista uomo di Neanderthal, è rimasto l’unico a regnare sulla terra. L’autore Gianfranco Pacchioni inizia da qui e riflette sul futuro dell’umanità. Esiste una minaccia, peggiore delle armi nucleari: l’intelligenza artificiale, se questa sarà capace di prendere decisioni in piena autonomia sarà anche in grado di dominare il mondo e rendere l’uomo schiavo della propria tecnologia. L’homo sapiens potrebbe “evolvere” nell’homo insipiens con il suo pieno affidamento alla tecnologia e il conseguente allontanamento dal sapere.

Foto da Datasys Magazine